我院刘兴武教授与中原AI院、中国科学院计算所、鹏城实验室等单位的合作者在Nature Machine Intelligence上发表文章Lossless Data Compression by Large Models。Nature Machine Intelligence是涵盖机器学习、机器人和人工智能的顶级期刊。本文提出基于大模型的无损数据压缩新范式LMCompress。LMCompress在四种媒体类型(文本、图像、视频和音频)上都表现出了压倒性的优势,比最优传统无损压缩的效率提升2倍以上。

文章解读

数据压缩是一项基础技术,使信息能够高效存储和传输。传统压缩方法从香农开始经过80年的研发和百万篇论文,已接近其理论香农上限,哪怕对无损压缩再改进1%都非常困难。1949年,著名的香农-韦弗模型提出了语义通讯(和有效传输)的概念:如果理解了需要传输的内容,就应该能更有效地传输信息(Shannon&Weaver, Recent Contributions to the Mathematical Theory of Communication)。80年来,人们一直在探索如何实现语义通信。尤其是最近,语义通讯成为6G通讯的一个核心问题。MDL和算术编码的发明人Jorma Rissanan就曾经和本文的作者之一讨论过他一直关心的语义传输。语义通信的关键挑战是,人们其实并不理解什么是真正的语义传输,香农他们没有定义,Rissanan也没有说明。莎士比亚说:一千个人眼中有一千个哈姆雷特。要确切找到所有“语义”本来就是一个不可完成的任务(用计算理论的术语:不可计算的)。

本文提出了“理解即压缩”的理论。本文作者曾从数学上证明了压缩蕴含理解,而本文用实验验证了另一个方向,即理解蕴含压缩。大模型的出现帮助作者们顺利完成了这个验证。经过大数据训练,文章作者认为一个大模型能够“理解”各种文件、照片、音频、视频,那么按照本文的理论,它就蕴含强大的压缩能力。类比人们熟知的理解式记忆,大模型压缩后的数据,就是大模型对数据的理解,即数据的“语义”。因此,越强大的大模型,越能理解语义,从而越能高效地压缩数据,彻底革新压缩技术。

相关工作:本文工作是和谷歌DeepMind团队(G. Deletang et al, Language modeling is compression, ICLR 2024)同时独立完成的。张平院士团队在 (Kai Niu and Ping Zhang, The mathematical theory of semantic communication, Springer Singapore, 2025) 中推广了传统香农信息论模型到语义通讯模型并证明了相对应的定理,形成一套完整的语义通讯理论。

研究方法

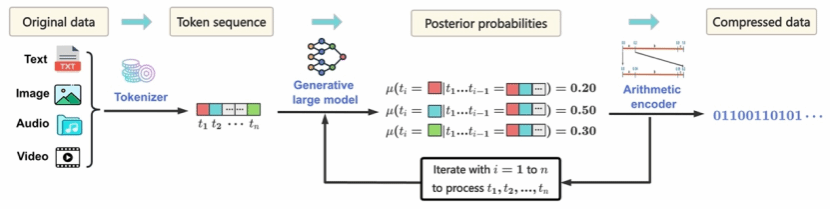

如图所示,LMCompress的工作原理为:

1. 大模型预测下一个token的概率分布。

2. 基于这些概率分布,使用算术编码进行无损压缩和解压。

LMCompress对大模型几乎没有限制,只要是自回归生成式大模型,都可以“即插即用”,只是解压缩时需要用同一个大模型。本文对不同数据类型选择不同的大模型:对文本,选用领域数据微调后的LLaMA 3;对于音频,使用ByteGPT;对于图像,使用image-GPT;对于视频,把各桢当做独立的图像,依然使用image GPT压缩。

研究结果

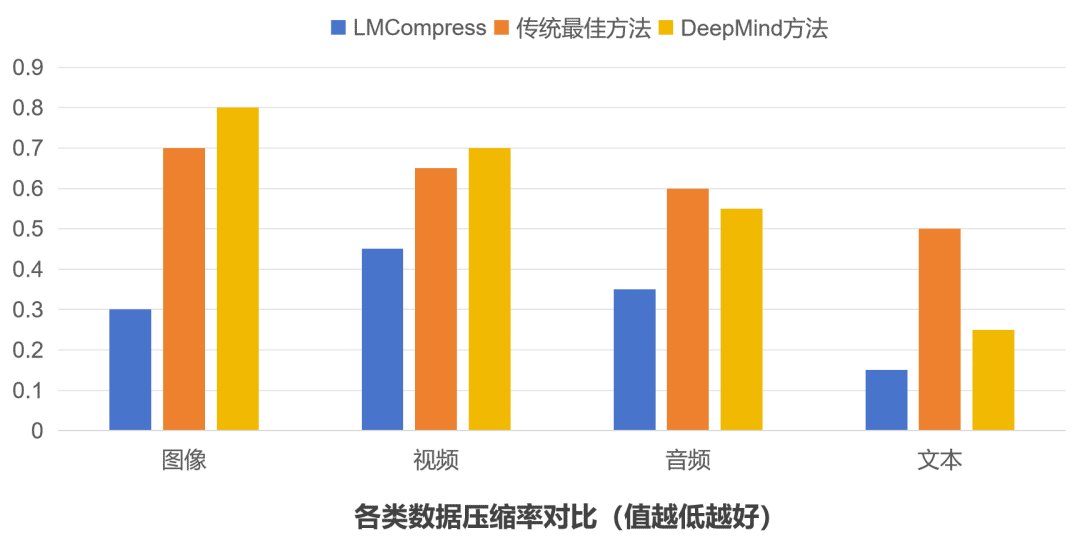

如下图所示,LMCompress在所有数据类型上都表现出色,显著优于传统方法,尤其在文本领域效果最为突出。

可见,LMCompress技术给无损压缩带来了惊人突破:

• 图像压缩率比JPEG-XL降低50%;

• 无论高分辨率还是低分辨率视频,压缩率都比H.265降低30%以上;

• 音频压缩率比OptimFROG降低50%;

• 文本压缩率比zpaq降低70%以上。

前景展望

LMCompress的一个可能应用场景是6G通信。卫星将在6G通信中发挥着更重要的作用,但是卫星带宽是非常紧缺的资源。通过在通信两端高效的编码和解码,将会大幅提升通信带宽的利用率。随着大模型理解能力的进一步提升,LMCompress提供了优美的解决方案。

当数据需要加密时,拥有高级模型的一方可以公开广播压缩信息,只有拥有同等模型的一方才能解码。因此,LMCompress可以作为第一级加密方案。

理解即压缩,就像学霸记笔记——理解得越透彻,笔记就越简练。AI对数据内容理解得越深,压缩效率就越高。这项突破不仅让手机内存节省出更多空间,未来看高清电影更流畅,更揭示了人工智能"读懂世界"的惊人潜力。当科技真正学会"理解",改变就在眼前!

参考文献:Z. Li, C. Huang, X. Wang, H. Hu, C. Wyeth, D. Bu, Q. Yu, W. Gao, X. Liu, M. Li, Lossless data compression by large models, Nature Machine Intelligence, 2025, May 1.

文章链接:https://www.nature.com/articles/s42256-025-01033-7